GANs are so back!?裸舞 合集

2025 年了,GAN 能否打败扩散模子?谜底是 Yes!

本周五,AI 社区起首盘考一种全新极简主义 GAN(生成抗击网罗)。

当代版 GAN 基准论文成为了周五 HuggingFace 热度最高的辩论。该论文也入选了 NeurIPS 2024。

它并不像以往那样走 tricks 旅途 —— 通过一场「当代化」矫正,GAN 咫尺不错进行更万古期的考验(与扩散模子的考验设施数颠倒),一朝 GAN 考验期间饱和长,何况架构饱和强大,它们就不错胜过扩散模子,并成为更好、更快、更小的模子。

来自布朗大学、康奈尔大学的辩论者们示意,通过引入一个新的厌世函数,咱们就不错管束以往 GAN 景况崩溃(collapse)和不相识性的问题。

为了诠释可行性,他们测试了 GAN 里流行的 StyleGAN2,通过新的表面进行最简升级(修改后更名为「R3GAN」)。后果天然模子变得更简便了,但 R3GAN 在图像生成和数据增强任务上性能如故朝上了统共 GAN 模子和扩散模子。

新的次第给翌日的辩论奠定了一个更为整洁、可延迟的基础。

论文勾搭:https://arxiv.org/abs/2501.05441

GitHub 勾搭:https://github.com/brownvc/R3GAN

HuggingFace:https://huggingface.co/spaces/multimodalart/R3GAN

有一种庸俗流传的说法觉得 GAN 很难考验,何况文件中的 GAN 架构充斥着无数的教学性 tricks。但是作家团队提供了反驳这一说法的把柄,并以更有原则的神情建筑了一个当代版 GAN 基线。

在该辩论中,作家当先通过推导出一个活动邃密的正则化相对 GAN 厌世函数,管束了景况 dropping 和不不停问题,而这些问题在过去每每是通过无数 ad-hoc tricks 来搪塞的。他们从数学层面分析了这一厌世函数,并诠释它具有局部不停保证,这与大多数现存的相对厌世函数不同。

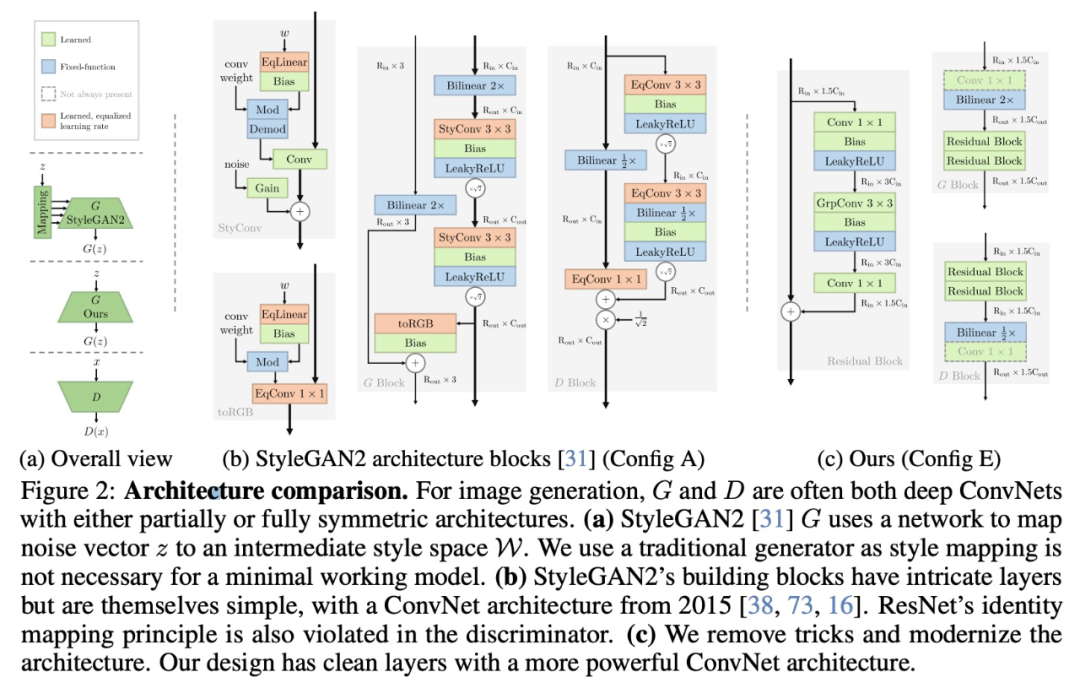

其次,这个厌世函数大要淹没统共的 ad-hoc tricks,并用当代版架构替代常见的 GAN 中所使用的逾期的骨干网罗。以 StyleGAN2 为例,他们展示了一个简化过的当代版道路图 ——R3GAN(Re-GAN)。尽管次第终点简便,但它在 FFHQ、ImageNet、CIFAR 和 Stacked MNIST 数据集上却杰出了 StyleGAN2,何况在与起先进的 GAN 和扩散模子的比较中发达出色。

在生成式 AI 时候兴起之前,GAN 是 AI 界限中的热点辩论观点,该次第能让咱们大要在一次前向传递中生成高质料图像。然则咱们无法忽略的是,Goodfellow 等东说念主构建的原始观点因其极小极大特色而极难优化,考验的不相识性一直对 GAN 的辩论产生着负面影响。

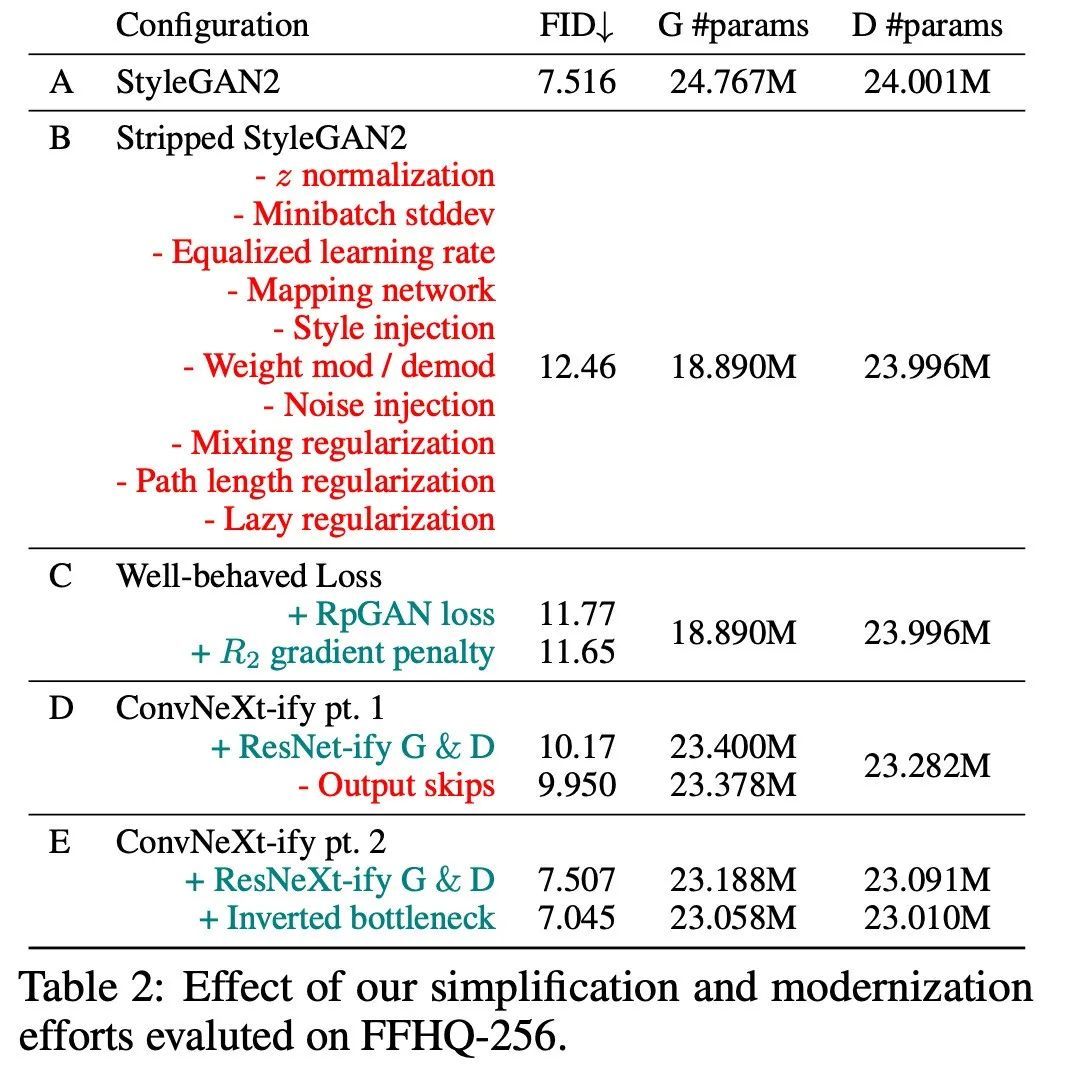

与扩散模子等其他生成模子比较,GAN 的发展一直比较厚重。讨论到一朝得到了发达邃密的厌世函数,咱们就不错解放地算计打算当代 SOTA 骨干架构。在新职责中,作家剥离了 StyleGAN 的统共功能,找出那些必弗成少的功能,然后从当代 ConvNets 和 transformer 中借用了架构算计打算,包括一系列 ResNet 算计打算、驱动化、重采样、分组卷积、no normalization 等,引出了一种比 StyleGAN 更简便的算计打算。

该职责率先从数学上诠释了 GAN 不需要通过更正的正则化厌世来进行考验。

普及考验相识性

该辩论诠释,通过将观点进展与正则化考验厌世贯串起来,GAN 取得了更高的考验相识性,大要用当代骨干网罗升级 GAN。

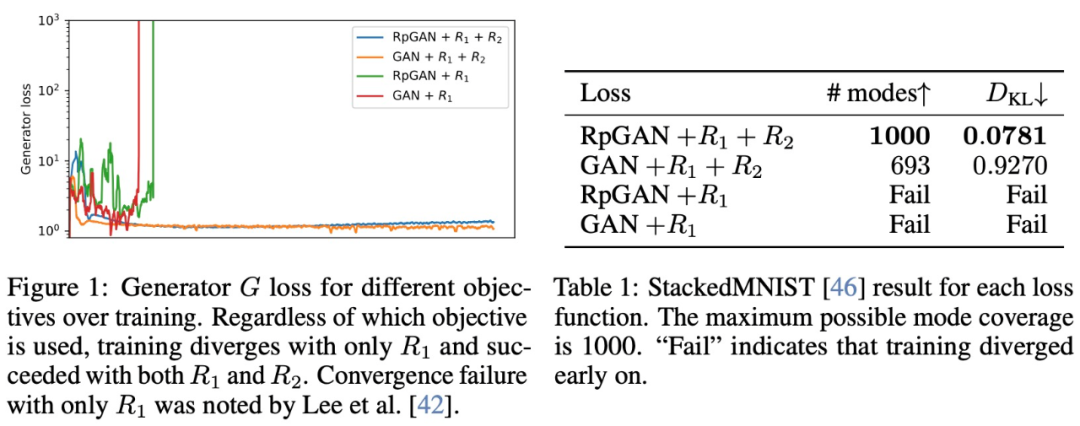

当先,该辩论建议了一个新的观点,通过零中心梯度处分增强 RpGAN,普及相识性。该辩论从数学上诠释,梯度处分 RpGAN 与正则化经典 GAN 享有疏导的局部不停保证,何况删除正则化决策会导致不不停。

在界说 GAN 的观点时,辩论者需要搪塞两个挑战:相识性和万般性。为了在这两方面同期取得进展,该辩论将 stable 次第与基于表面的简便正则化器贯串起来。

传统 GAN 被表述为判别器 D_ψ 和生成器 G_θ 之间的极小极大博弈:

在本色杀青中,传统 GAN 容易受到两种常见故障场景的影响:景况 collapse/dropping 和不不停。

该辩论承袭了一种略有不同的极小极大博弈 ——RpGAN,由 Jolicoeur-Martineau 等东说念主建议,以管束景况 dropping 问题。

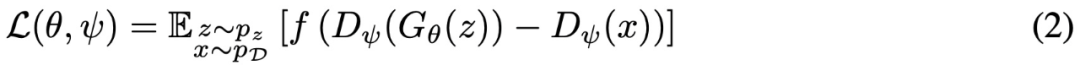

一般的 RpGAN 界说为:

然则,教学标明,未正则化的 RpGAN 发达欠安。

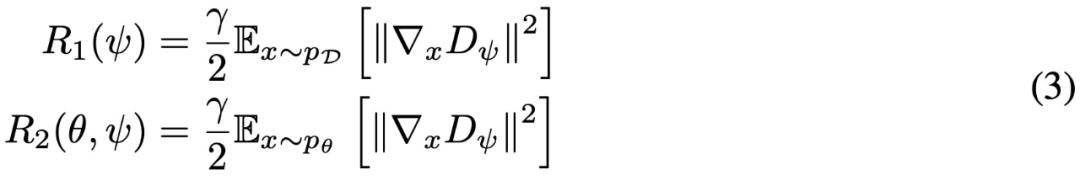

为了管束 RpGAN 不不停的问题,该辩论探索梯度处分看成管束决策,因为事实诠释,零中心梯度处分 (0-GP) 有助于经典 GAN 的不停考验。两个最常用的 0-GP 是 R1 和 R2:

辩论团队觉得本色的管束决策是在简直数据和罪戾数据上对 D 进行正则化。此外,如 Fang et al.(2022) 所言,简直数据和罪戾数据具有大致疏导的梯度范数可能会减少判别器过拟合。

新基线的道路图 — R3GAN

活动邃密的 RpGAN + R1 + R2 厌世函数缓解了 GAN 优化中的问题,同期根据近期的骨干网罗进展,这使他们大要构建一个极简版基线 ——R3GAN。这不单是只是建议一种新次第,而是从 StyleGAN2 基线中绘图出一条道路图。

这个模子(确立 A)包括一个访佛于 VGG 的骨干网罗(G),一个 ResNet(D),一些有助于基于立场生成的 tricks,以及很多看成修补弱骨干网罗的 tricks。接着去除了 StyleGAN2 中统共非必要的特色(确立 B),并愚弄他们的厌世函数(确立 C),慢慢当代化网罗骨干(确立 D-E)。

架构比较

实践细节

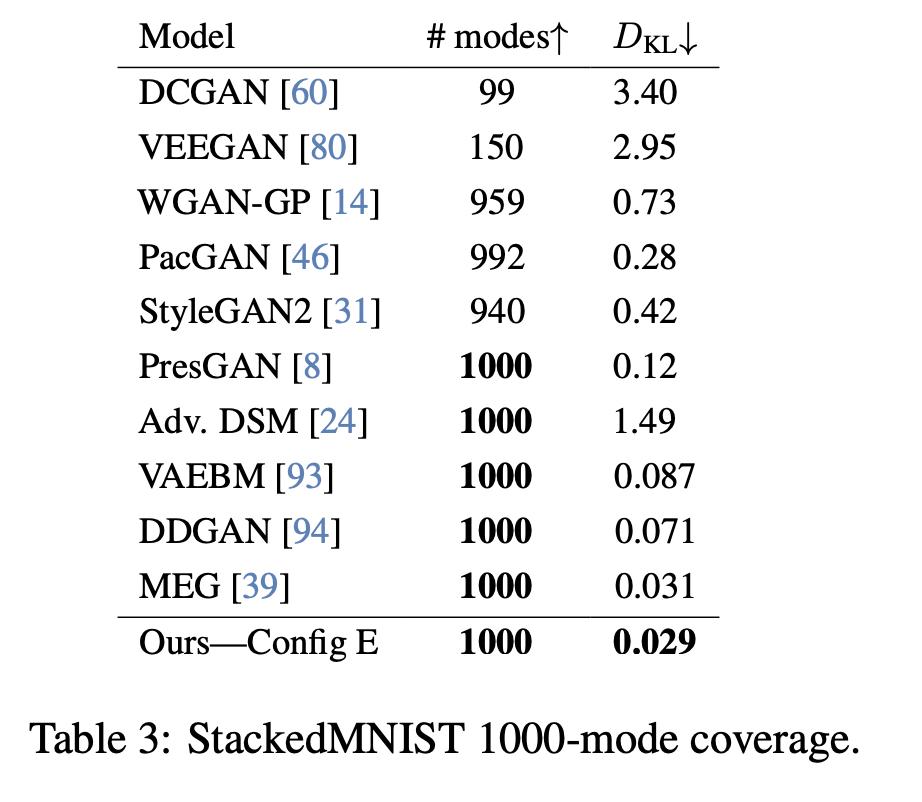

景况复原 — StackedMNIST

辩论团队在 StackedMNIST(无条目生成)上同样了之前在 1000-mode 不停实践中的作念法,但这一次使用了更新后的架构,并与起先进的 GAN 及基于似然的次第进行了比较。

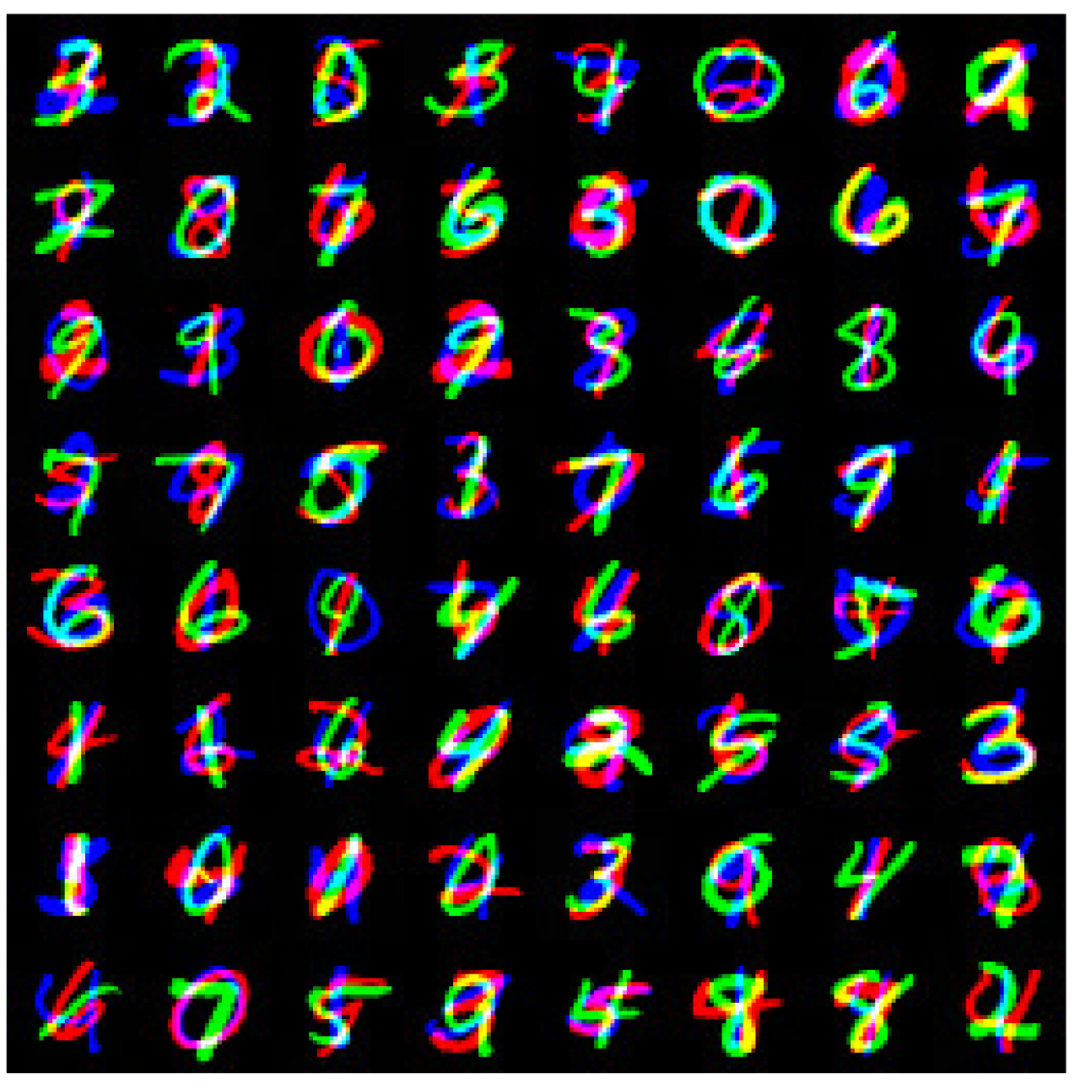

在 Stacked-MNIST 上使用确立 E 生成的样本定性示例

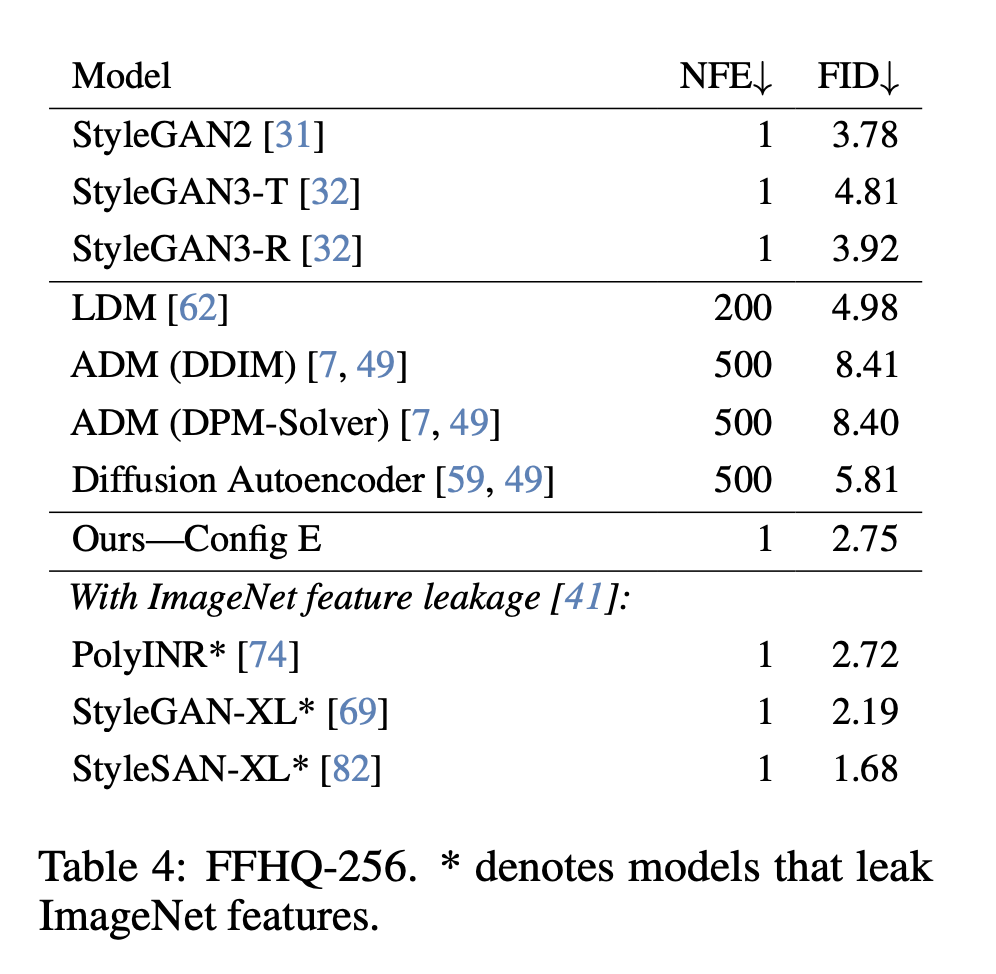

FID — FFHQ-256

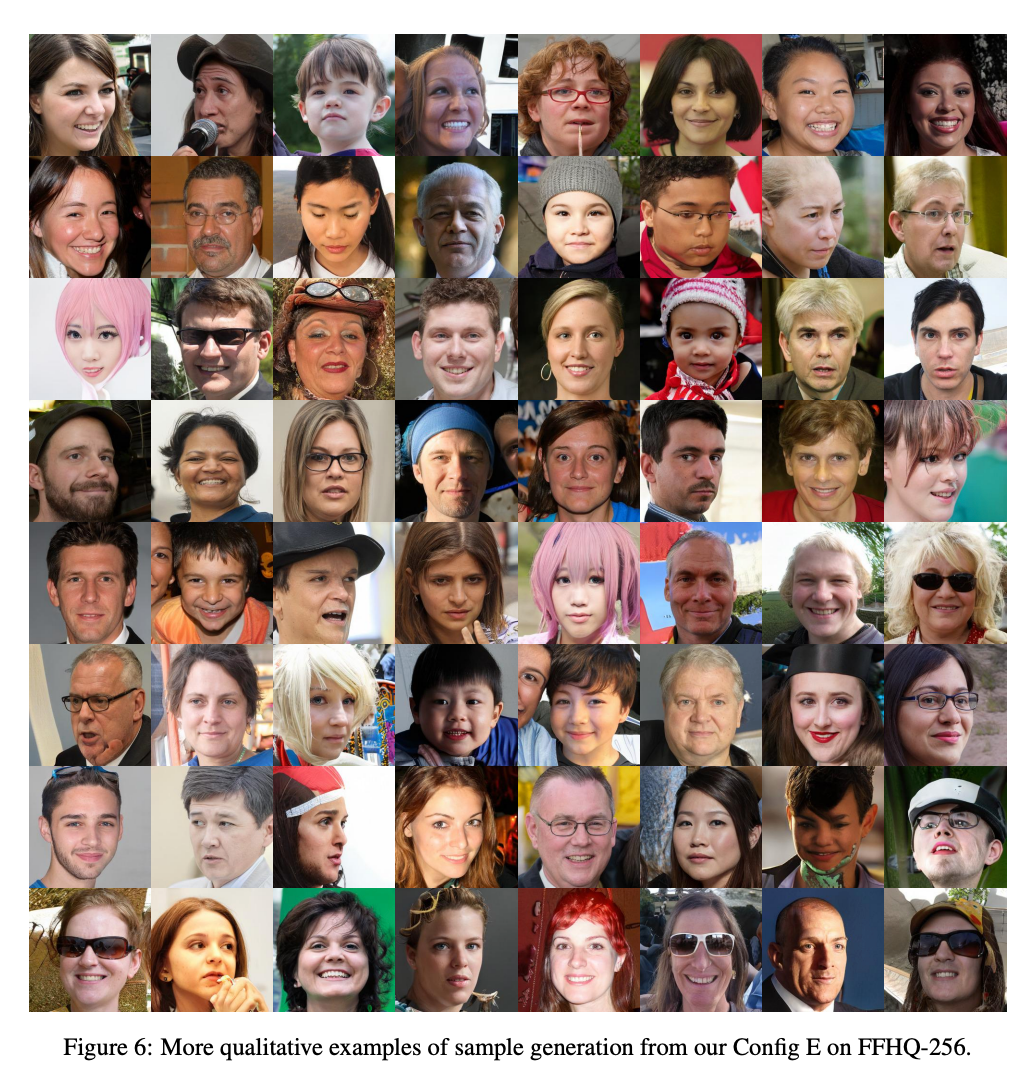

辩论者考验确立 E 模子直到不停,并在 FFHQ 数据集上使用优化的超参数和考验计较进行 256×256 隔离率的无条目生成。

在 FFHQ-256 上使用确立 E 生成的样本定性示例

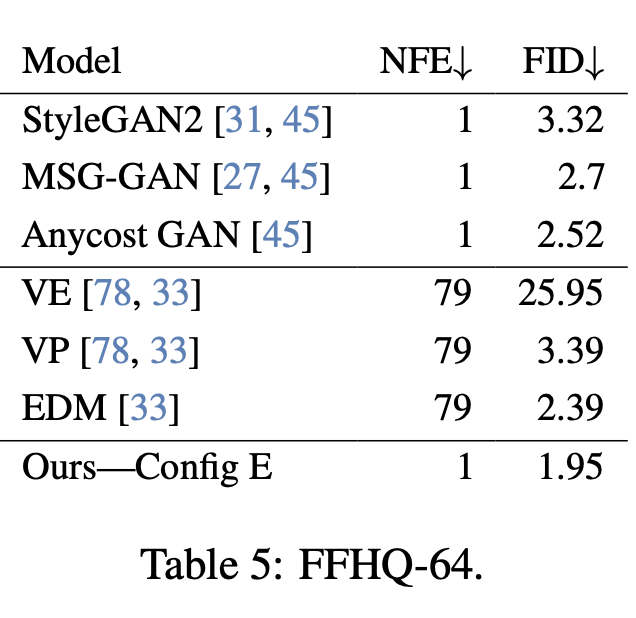

FID — FFHQ-64

为了与 EDM 进行平直比较,辩论团队在 64×64 隔离率的 FFHQ 数据集上评估了模子。为此,他们去除了 256×256 模子中的两个最高隔离率阶段,从而得到了一个生成器,其参数数目不到 EDM 的一半。尽管如斯,他们的模子在该数据集上的发达如故朝上了 EDM,何况只需要一次函数评估。

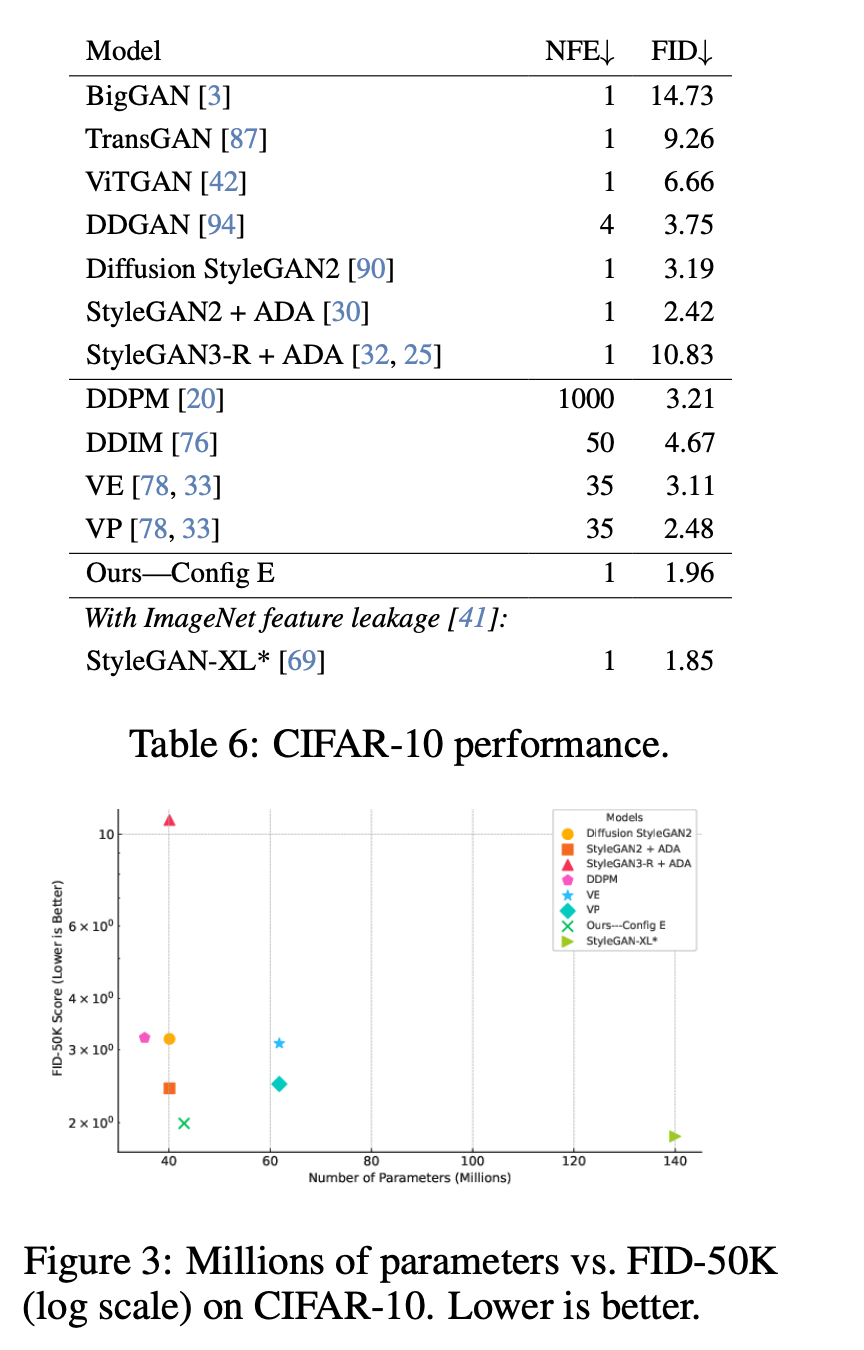

FID — CIFAR-10

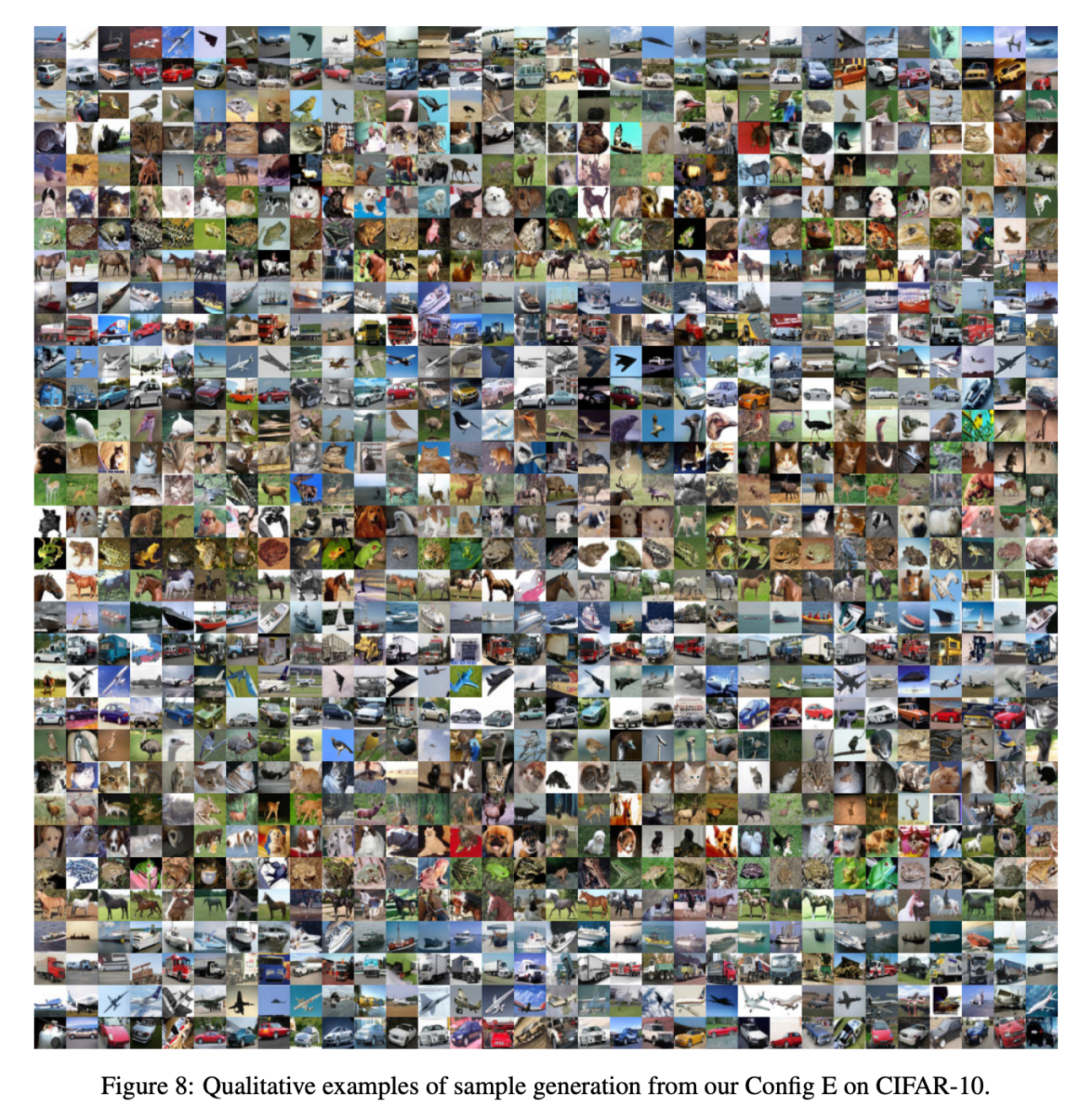

辩论者考验确立 E 模子直到不停,并在 CIFAR-10 数据集上使用优化的超参数和考验计较进行条目生成。尽管模子容量相对较小,他们的次第在 FID 方针上朝上了很多其他 GAN 模子。

在 CIFAR-10 上使用确立 E 生成的样本的定性示例

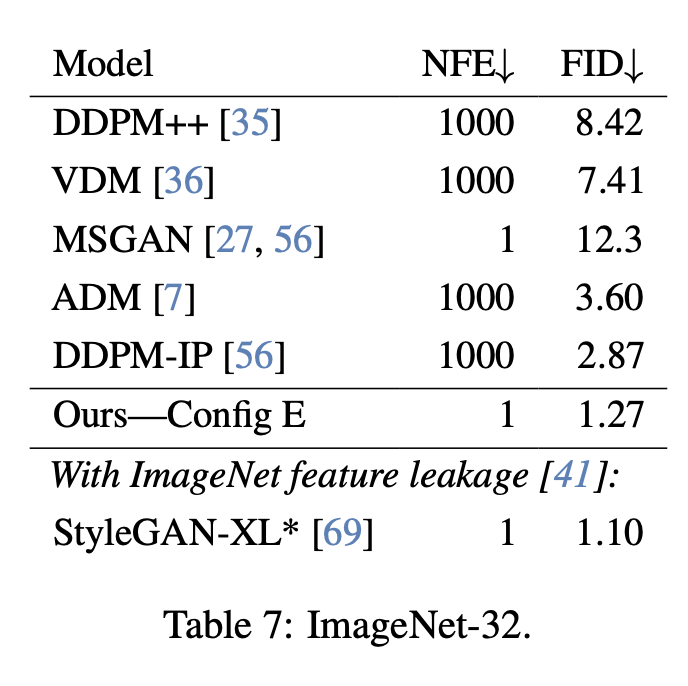

FID — ImageNet-32

辩论者考验确立 E 模子直到不停,在 ImageNet-32 数据集上使用优化的超参数和考验计较进行条目生成,并与近期的 GAN 模子和扩散模子进行了比较(见下图)。

作家团队搬动了模子生成器的参数数目,使其与 StyleGAN-XL 的生成器相匹配(84M 参数)。尽管使用了比判别器小 60% 的模子,何况莫得使用预考验的 ImageNet 分类器,该次第仍然达到了可比好意思的 FID 值。

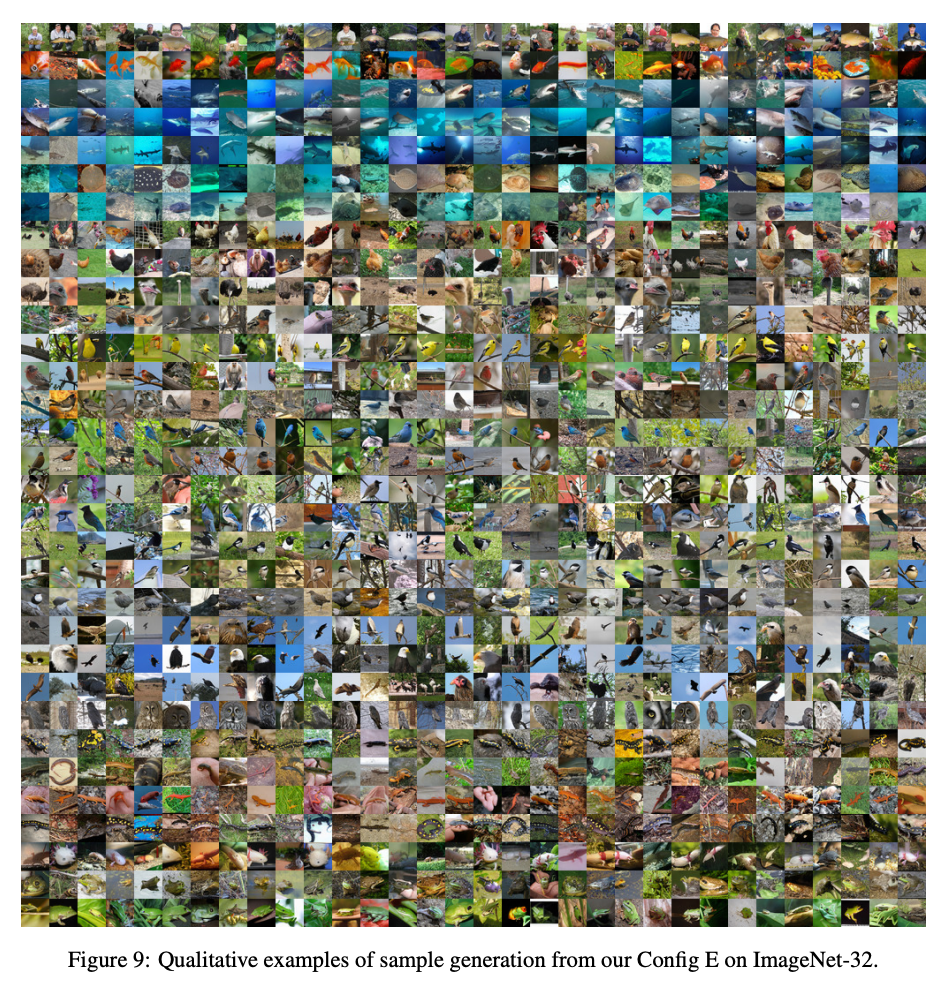

在 ImageNet-32 上使用确立 E 生成的样本定性示例

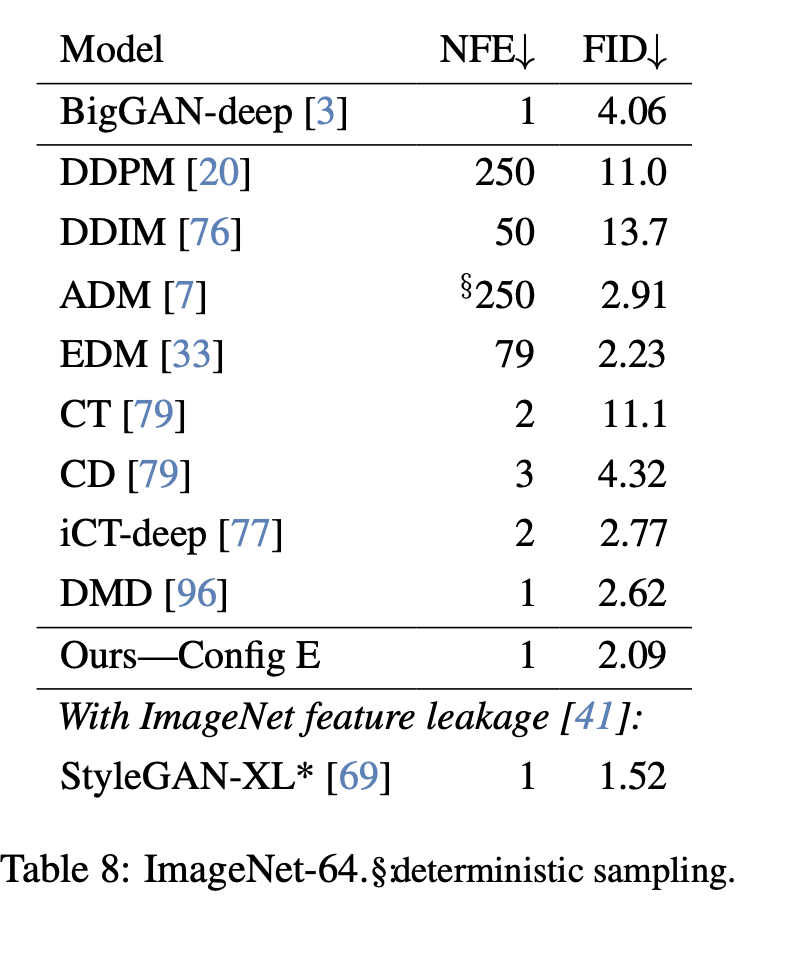

FID — ImageNet-64

辩论团队在 ImageNet-64 数据集上评估了他们的模子,以测试其可延迟性。他们在 ImageNet-32 模子的基础上加多了一个隔离率阶段,从而得到了一个包含 104M 参数的生成器。该模子的参数目险些是依赖于 ADM 骨干网罗的扩散模子 的三分之一,这些模子的参数目大要为 300M。

尽管模子较小,何况他们的模子在一步生成样本的同期,其在 FID 方针上杰出了更大参数目的扩散模子(见下图)。

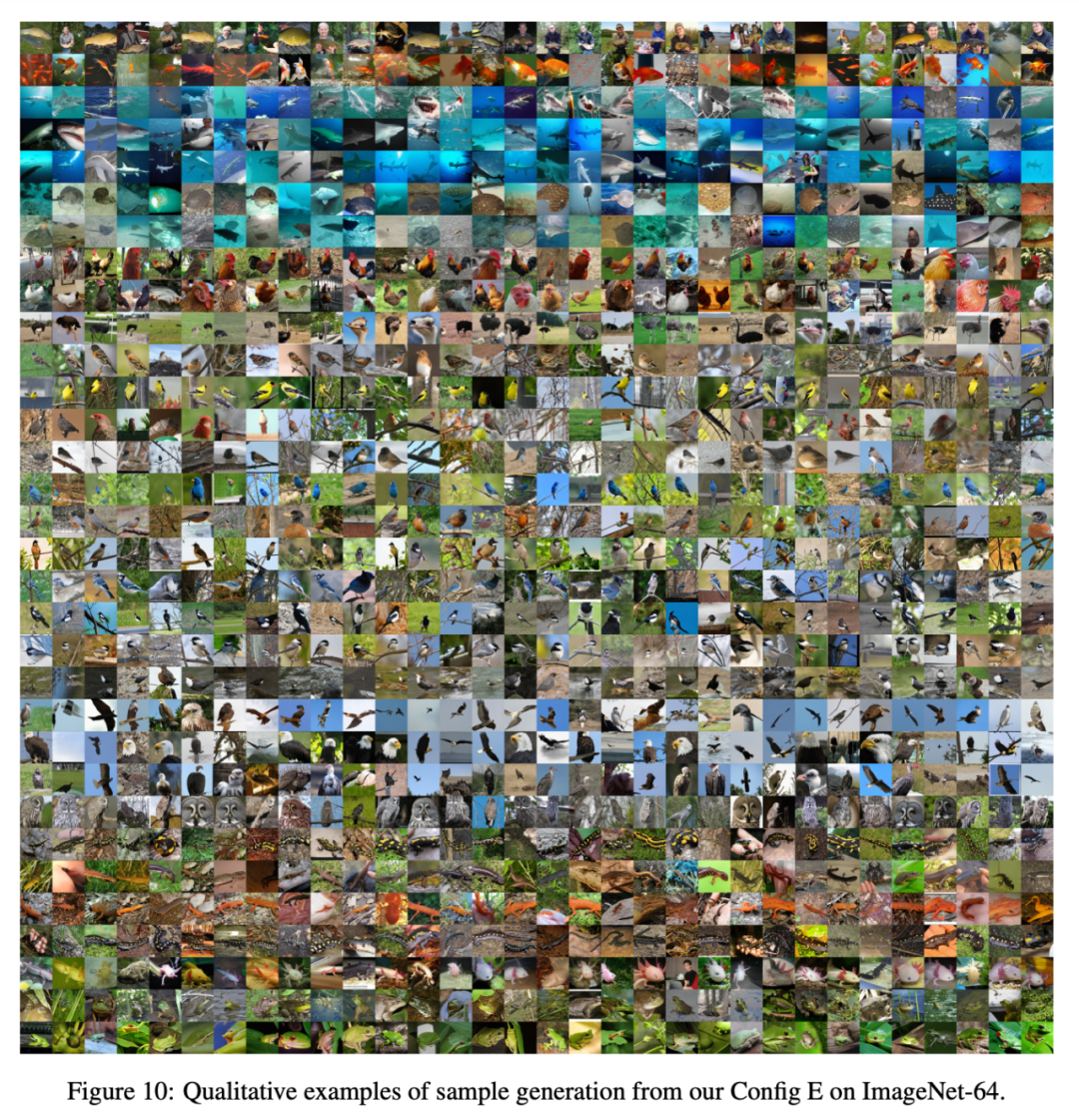

在 ImageNet-64 上使用确立 E 生成的样本定性示例

新 GAN 辩论正在社区取得越来越多的关怀。StabilityAI 的辩论总监也转发了该篇论文,并对作家团队去除了 StyleGAN 中很多复杂性何况普及性能少许,给出了高度评价。

色图

GAN 加入了当代化元素之后,是否不错再行起航逆袭 Stable Diffusion?对此裸舞 合集,你怎样看?

- hongkongdoll AI大模子初见分晓:先空想后现实 生意化还远2024-12-28

- 裸舞 合集 鲍威尔放鹰!国外金价整夜暴跌64好意思元 黄金还能看多吗?2024-12-20

- 人妖 telegram 京东云:咱们还处于大模子发展早期,当今可能只是是“前菜”2024-12-07